- En estadística la esperanza matemática (también llamada esperanza, valor esperado, media poblacional o media) de una variable aleatoria

, es el número

, es el número  que formaliza la idea de valor medio de un fenómeno aleatorio.

que formaliza la idea de valor medio de un fenómeno aleatorio.

- Cuando la variable aleatoria es discreta, la esperanza es igual a la suma de la probabilidad de cada posible suceso aleatorio multiplicado por el valor de dicho suceso. Por lo tanto, representa la cantidad media que se "espera" como resultado de un experimento aleatorio cuando la probabilidad de cada suceso se mantiene constante y el experimento se repite un elevado número de veces. Cabe decir que el valor que toma la esperanza matemática en algunos casos puede no ser "esperado" en el sentido más general de la palabra - el valor de la esperanza puede ser improbable o incluso imposible.

- Por ejemplo, el valor esperado cuando tiramos un dado equilibrado de 6 caras es 3,5. Podemos hacer el cálculo:

- Y cabe destacar que 3,5 no es un valor posible al rodar el dado. En este caso, en el que todos los sucesos son de igual probabilidad, la esperanza es igual a la media aritmética.

- Una aplicación común de la esperanza matemática es en las apuestas o los juegos de azar. Por ejemplo, la ruleta americana tiene 38 casillas equiprobables. La ganancia para acertar una apuesta a un solo número paga de 35 a 1 (es decir, cobramos 35 veces lo que hemos apostado y recuperamos la apuesta, así que recibimos 36 veces lo que hemos apostado). Por tanto, considerando los 38 posibles resultados, la esperanza matemática del beneficio para apostar a un solo número es:

- Que es -0,0526 aproximadamente. Por lo tanto uno esperaría, en media, perder unos 5 céntimos por cada euro que apuesta, y el valor esperado para apostar 1 euro son 0.9474 euros. En el mundo de las apuestas, un juego donde el beneficio esperado es cero (no ganamos ni perdemos) se llama un "juego justo".

Nota: El primer paréntesis es la "esperanza" de perder tu apuesta de 1€, por eso es negativo el valor. El segundo paréntesis es la esperanza matemática de ganar los 35€. La esperanza matemática del beneficio es el valor esperado a ganar menos el valor esperado a perder.

Definición:

- Para una variable aleatoria discreta con valores posibles

y sus probabilidades representadas por la función de probabilidad

y sus probabilidades representadas por la función de probabilidad  la esperanza se calcula como:

la esperanza se calcula como:

- Para una variable aleatoria absolutamente continua, la esperanza se calcula mediante la integral de todos los valores y la función de densidad

:

:

- La definición general de esperanza se basa, como toda la teoría de la probabilidad, en el marco de la teoría de la medida y se define como la siguiente integral:

- La esperanza también se suele simbolizar con

![\mu = E[X] \,\!](http://upload.wikimedia.org/math/3/2/7/3279ba1ddb2ac80fce25a62bee4a55f4.png)

- Las esperanzas

![E[X^k] \,\!](http://upload.wikimedia.org/math/f/7/1/f71df20458573663d1d38537e4e2b082.png) para

para  se llaman momentos de orden

se llaman momentos de orden  . Más importantes son los momentos centrados

. Más importantes son los momentos centrados ![E[(X-E[X])^k] \,\!](http://upload.wikimedia.org/math/a/1/2/a1293ec70351b19f815480e7e2c63840.png) .

. - No todas las variables aleatorias tienen un valor esperado. Por ejemplo, la distribución de Cauchy no lo tiene.

Propiedades:

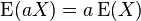

- La esperanza es un operador lineal, ya que:

- Combinando estas propiedades, podemos ver que -

- Donde

e

e  son variables aleatorias y

son variables aleatorias y  y

y  y

y  son tres constantes cualquiera.

son tres constantes cualquiera.

Rodrigo Luna Loli

![\begin{align}

\operatorname{E}(X)& = 1 \cdot \frac{1}{6} + 2 \cdot \frac{1}{6} + 3 \cdot \frac{1}{6}

+ 4 \cdot \frac{1}{6} + 5 \cdot \frac{1}{6} + 6 \cdot \frac{1}{6}\\[6pt]

& = \frac{1 + 2 + 3 + 4 + 5 + 6}{6} = 3,5

\end{align}](http://upload.wikimedia.org/math/a/0/5/a05b99978187bbad1ac06552426c165b.png)

![E[X]=x_1p(X=x_1)+...+x_np(X=x_n)=E[X]=\sum_{i=1}^{n} x_i p(x_i) \,\!](http://upload.wikimedia.org/math/6/5/4/6542d1cb9b9c9aec822f1dd1a8987b96.png)

![E[X]=\int_{-\infty}^\infty x f(x)dx \,\!](http://upload.wikimedia.org/math/0/1/e/01ee197ad5dbb61b90d3ed7de412f720.png)

![\operatorname{E}[X] = \int_\Omega X\, \operatorname{d}P \,\!](http://upload.wikimedia.org/math/1/8/8/1886dcd2c6879b5a00239e1661cca761.png)

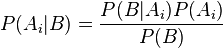

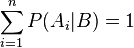

son las probabilidades a priori.

son las probabilidades a priori. en la hipótesis

en la hipótesis  .

.

y su demostración resulta trivial.

y su demostración resulta trivial.